AI机器人竞选市长了!

没错,这种存在于科幻小说中的剧情如今照进了现实生活中。近日,日本一个机器人提名为多摩市市长候选人,承诺将对所有市民一视同仁,不偏不倚,竞选口号为“为每个人提供公平、均等的机会”。

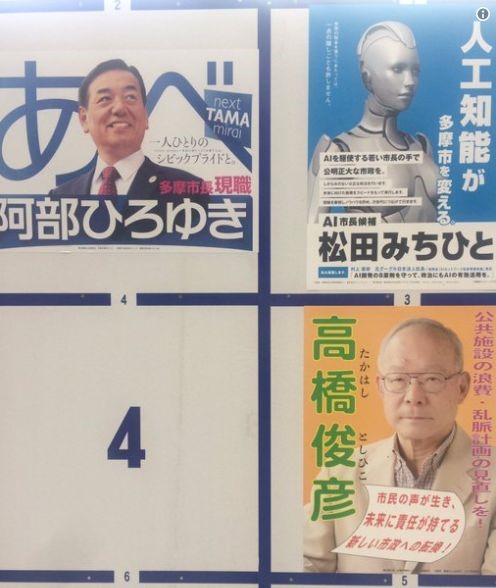

机器人竞选日本多摩市市长

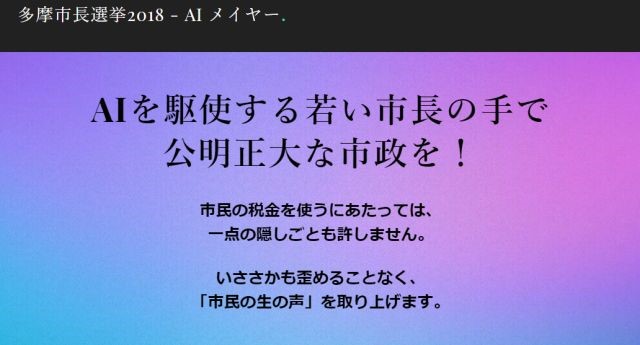

起初人们以为这仅是竞选者的cosplay,而后来发现,这是一个如假包换的机器人,其后AI候选人开通了自己的官方推特宣传账号,还给出了自己竞选的政见:让政治变得更加公平。

其后,机器人还列举出了自己的几大竞选优势:其一,机器人没有情绪也没有欲望,在处理政务时,既不会夹带私人感情也能防止腐败;其二,机器人不用休息,可以长时间高强度工作;其三,相对人类随着年龄增长的记忆力退化,机器人可以始终保持大量信息存储……

图源:AImayor

无独有偶,此前的一位来自新西兰的机器人公务员“萨姆”也赚足了眼球,“萨姆”能够回答市民提出的有关住房、教育和移民的问题,而且其自己曾“表示”,在做决定时将会考虑每个人的立场。

事实真的如此吗?机器人当市长这件事儿靠谱吗?智能相对论(ID:aixdlun)分析师柯鸣认为,想要机器人真正胜任市长一职,甚至让机器人大范围的替代传统公务员,不得不思考这几个问题。

机器人能否成为道德主体?

既然要办事,那么就要为自己可能出现的错误承担责任。但机器人是否能够独立承担自身责任成为道德主体呢?我们先来看看著名的约翰·希尔勒(John Searle)“中文房间”实验:

想象一位只说英语的人身处一个房间之中,在封闭的房间中其只携带一本写有中文翻译程序的书。写着中文的纸片通过小窗口被送入房间中。根据Searle,房间中的人可以使用他的书来翻译这些文字并用中文回复。虽然他完全不会中文,Searle认为通过这个过程,房间里的人可以让任何房间外的人以为他会说流利的中文。

约翰·希尔勒(John Searle)“中文房间”实验

当然,“中文房间”实验也引起了起了人们对于人工智能的一些争论。 但在这场争论中,人们并没有排除人工智能体自主道德设计的可能性,而实际上人工智能体的设计与智能体作为道德主体的建立还是有区别的。关于意识、理解力等概念的认识与如何才能使机器人的行为符合道德规范的实际议题基本上是不相干的。

那么,我们再来看看人类道德在机器人领域是否有一定的适用性。道德规范在我们的日常生活中普遍存在,也存在于有组织的社会活动中,在马克思看来,道德是对特定经济基础反应的上层建筑。

但由于人工智能科学日新月异,以及自主机器人广泛的存在与应用,自主机器人早已参与了我们缤纷多彩世界中的生活,世界不论怎样都已不得不讨论自主机器人的道德地位了。

温德尔·瓦拉赫与科林·艾伦教授合著的《道德机器:如何让机器人明辨是非》一书中对于机器人是否应当或者能够担负起道德责任、人工道德智能体(AMAs)提出了解决方案:一种是自上而下式的理论进路,是指通过将机器人所要掌握的知识与能力转化为一系列算法规则,把这些规则植入机器人的“大脑”,从而获得“认知”;另一种是自下而上式的发展进路则是通过模拟孩童的成长过程,让机器人在不同环境的相互作用中习得复杂行为与认知的能力与知识。

从目前服务类(如公务员)机器人的表现来看,其深度学习、高度自动化等依然是其固有痼疾的基础上,谈论机器人自身的道德主体性也许行之过早了。

机器人公务员真的能够毫无偏见吗?

从日本AI机器人竞选市长到新西兰机器人“萨姆”,无一不是宣扬其具有公正性、无任何私情。然而,在还未到达“超人工智能”的当下,机器人难以形成自身思想之前,算法的偏见,似乎一直都是难以克服并为人诟病之处。

所谓的“算法偏见”是指在看似没有恶意的程序设计中,却不自觉的带有设计人员或开发者的偏见,或者中拟定程序的过程中,采用的数据是具有一定偏见性的。这种情况带来的后果是巨大的,例如,Google搜寻被曲解、合格的考生无法进入医学院就学、聊天机器人在推特(Twitter)上散布种族主义和性别歧视信息等。

算法偏见造成最棘手的问题之一是,从事程序设计的工程师,即便本身没有种族、性别、年龄歧视等倾向,也有可能造成偏见。AI本质上就是为了自行学习而设计,有时它的确会出错。

在AI招聘领域,一个最为典型的案例就是顶级管弦乐队选角,古典音乐过去一直以男性为主,但在20世纪70年代引入了盲目的试镜,这使顶级乐团的女音乐家增加了五倍以上。

但是,这并没有解决根本性的问题,第一批通过盲目试镜入选的女性依然无法融入日常演奏,乐队不得不寻找其他男性演奏家。

而我们的AI招聘:就像管弦乐队的幕布一样,机器学习是一种范式转变,有可能消除长期存在的偏见,但它本身并不能解决几个世纪的偏见。

回到机器人公务员领域,其工作内容中也不乏“价值判断”的部分,如材料完整度如何可以报账?组织部评价评优又是以何为尺度?而作为市长的日常事务的裁断更是需要一定的标准。而目前的机器人深度学习能够实现的就是“算法裁决”,这又再次落入了算法偏见的窠臼之中。

服务类公务员机器人,你敢安心让它上岗吗?

事实上,大众并不敢让机器人完全代替公务员工作,包括市长。

AI市长在日本的竞选中败了,而且很彻底。截止至最后日本多摩市的公投结果显示,“AI市长”仅获4013票,较现任多摩市长阿部裕行获得的34603票相距甚远。

《人工智能》里大卫和妈妈的一段对话让人印象深刻。当大卫询问妈妈晚饭吃什么时,妈妈告诉它,机器人是不能吃饭的。大卫却说:“我知道,但是我喜欢和家人一起坐在餐桌上。”正如剧中男主角所说,大卫既然懂得爱,那他也应该懂得恨。当人工智能愈发先进、愈发智能时,人类会不会被科学这把利刃划破双手?

正如当下机器人动手术、机器人管理金融等领域,许多人对此依然无法完全信任。机器人终究是少了一点“人气”,在公务员领域,没有了面对面的嘘寒问暖,只是例行公事地办证取证,工作似乎也少了许多乐趣。

此外,机器人公务员的应用范围也是相当狭窄的。从目前来看,随着世界数据化程度不断加深,与个人相关的数字类信息可由机器人逐步替代,如社保处理、出国签证、纳税等;另一类型的公务员机器人则与富士康工场里机器人替代传统的工人类似,通过生物识别确认人员身份等类型的工作均可由机器人充当。

但是,AI也未达到完美的程度。比如许多开发者经常会把他们的偏见写入人工智能项目,最近一项研究也发现,AI的语言翻译工具已经具有种族主义和性别歧视的偏见。

阿西莫夫在《我,机器人》一书中曾提出机器人三定律:

第一定律:机器人不得伤害人类个体,或者目睹人类个体将遭受危险而袖手不管;第二定律:机器人必须服从人给予它的命令,当该命令与第一定律冲突时例外;第三定律:机器人在不违反第一、第二定律的情况下要尽可能保护自己的生存。

显然,目前机器人仍然遵循着这基本的要求,但随着机器人技术的日益发展,会有更多类型的机器人出现,当真正机器人与人类伦理发生冲突时,如何协调人工智能与人类的关系也将成为当今时代下必须重视的课题。

当然,也希望霍金的预言永远也不会成为现实。